頭の体操がしたい!

こんにちは、マルチタスク専門家のくらゆーです。

読書レビューが遠退きかけていますが、頑張ってアウトプットを途絶えないようにしたいものです。

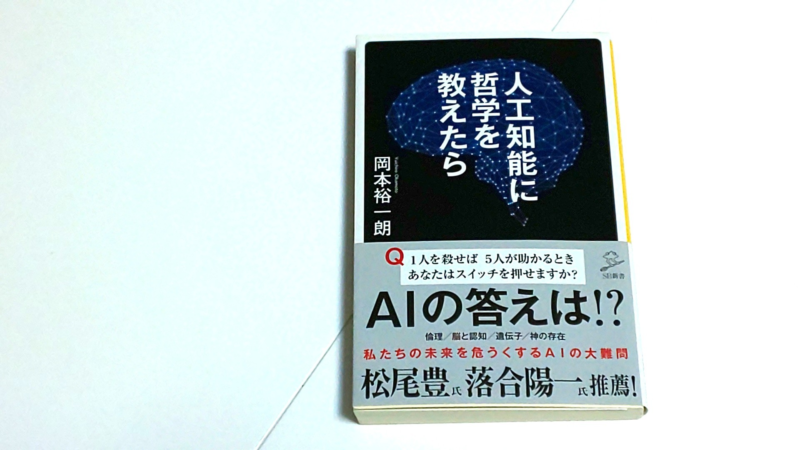

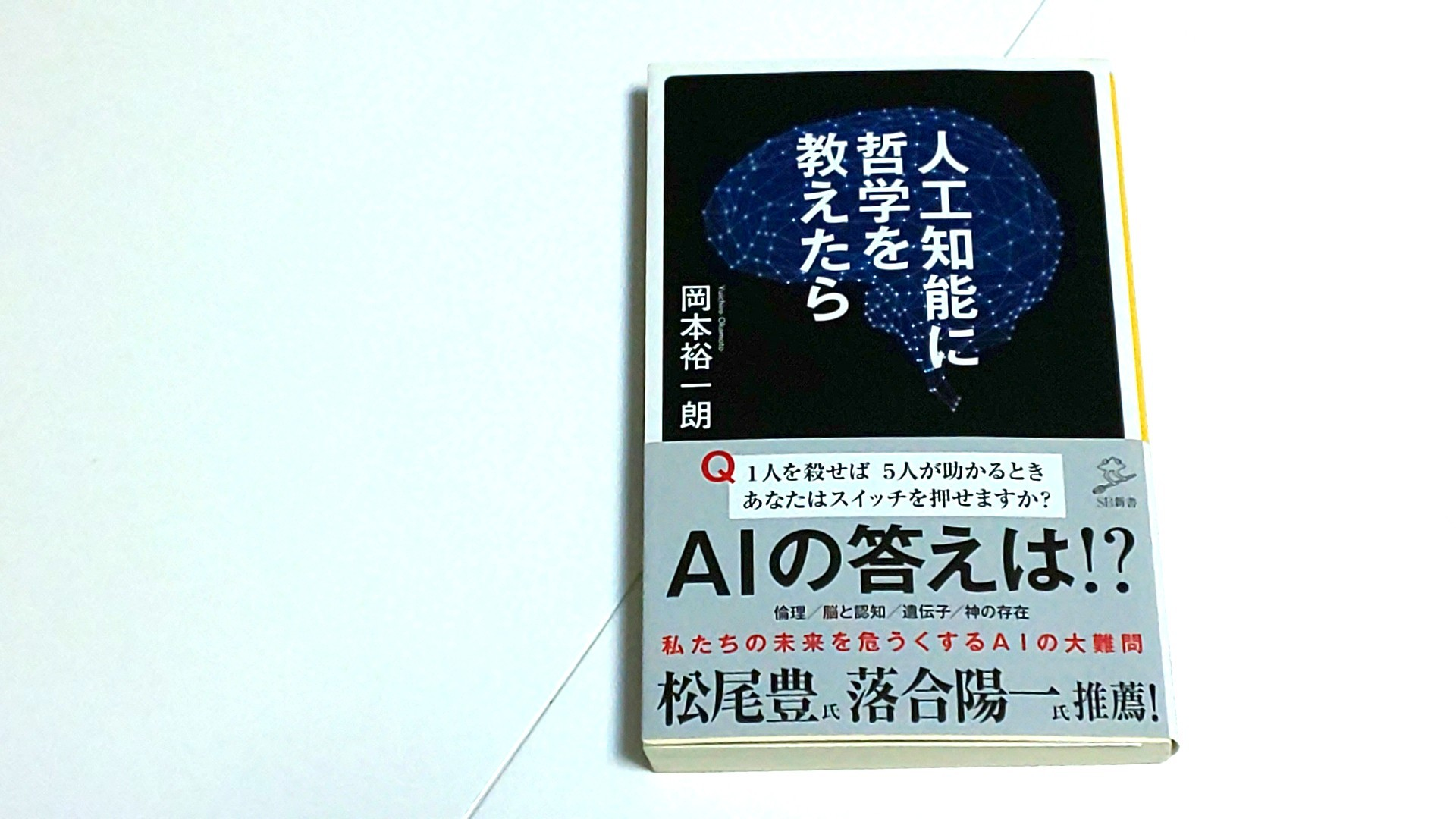

さて、本記事では岡本裕一朗さんの著書『人工知能に哲学を教えたら』(SB新書)を読んだ感想をレビューします。

感想

裏表紙にも書いているのですが、本書は「人工知能に哲学を教えてみたら、いったいどうなるか。考えてみよう!」という現実世界で実験ができないことを頭の中で試してみるという思考本です。

SFっぽくもありますが、人工知能ができることの知識を深めるとともに、人工知能と人間との役割を再認識する意味でも読んでいて興味深かったです。

また、挿絵に入ってくる漫画のタッチがなかなかパンチ効いててこの手のビジネス書にしてはかなり楽しめる1冊となります。

第1章『AI vs 正義』人工知能に倫理を教えられるか

第2章『AI vs 脳』人工知能にとって「認知」とは何か?

第3章『AI vs 芸術家』人工知能はアートを理解できるか?

第4章『AI vs 恋愛』人工知能にとって幸福とは何か?

第5章『AI vs 労働者』ロボットは仕事を奪うか?

第6章『AI vs 宗教』人工知能は「神」になるか?

第7章『AI vs 遺伝子』人工知能は人類を滅ぼすか?

特に興味深かった箇所を僕なりにピックアップします。

ピックアップ

第1章の1「自動車が抱えた大問題」

ここでは、読者への例題としてトロッコ問題が投げ掛けられます。

「ブレーキが効かなくなった車両がそのまま直進すれば5人の作業員を轢き、スイッチで進路を変えれば1人の作業員を轢いてしまう。どうする?」

ここ(この章)で気付くのは、「運転」というのは瞬時に直感を含む複数の判断を行っているのだということと、倫理的な選択をするシーンではプログラム化するのに様々な壁があり、難解さが付きまとうんだなと感じました。

トロッコ問題の種類が何パターンか出てくるので一緒に考えていくのがなかなか頭働いて面白いですよ!

第2章の2「「これが犬だよ」(直示的定義)の難しさ」

これもまた、例がおもしろいです。

子どもに犬を教えようとして犬を飼ってる家の前を通る度に「ワンワンだよ。」と教えていた(つもり)が、子どもがある日、プロパンガスを見て「ワンワン」と言うようになった。実は、犬を飼っていた家には(犬のすぐ近くに)プロパンガスが立っており、毎回親が通る度に「ワンワン」と教えるからプロパンガスを「ワンワン」として認知してしまったという例が取り上げられます。

んーおもしろいっ。

でもこれって仕事していると大人同士のコミュニケーションでもよくあるなと思います。解釈が異なって意図しない方向に話が進んでいることをよく目にすることがあります。

人間同士でも概念の定義が双方(伝える側と伝えられる側)で一致しないことがあるわけですから

人工知能にこの概念の定義を認知させる(機械的にプログラムする)ということがどれほど労力がかかることか想像を絶すると思います。ディープラーニングって凄いんですね。

以上、2つのみピックアップしましたが、全部の章を通して一緒に考えられる内容になっているので、思考本としてオススメします。

ではでは。

コメント